Släpp loss vilddjuret: Introducera artificiell intelligens på enkelt sätt i valfritt industrisystem

Det finns ett stort intresse för att tillämpa artificiell intelligens (AI) och maskininlärning (ML) i industriella miljöer för att öka produktiviteten och effektiviteten, och samtidigt uppnå besparingar i driftskostnaderna. Dock finns det — som alla ingenjörer eller teknikchefer brukar förklara — tre stora problem som behöver tas i beaktande när det gäller att lägga till epitetet "smart" på en installerad bas av "dumma" maskiner, från motorer till klimatanläggningar.

Först det första finns inte tillräckligt mycket folk med AI- och ML-expertis för att tillfredsställa efterfrågan, och de experter som finns är inte billiga. För det andra finns brist på kvalificerade datamängder på vilka AI- och ML-system kan tränas upp, och de datamängder som finns bevakas noggrant. För det tredje har AI- och ML-system traditionellt krävt avancerade processorplattformar för att köras på.

Det som krävs är ett sätt att göra det möjligt för befintliga ingenjörer och utvecklare utan AI- och ML-erfarenhet att snabbt skapa AI- och ML-system och installera dem på effektiva, billiga microcontrollerplattformar. Ett intressant start-up som heter Cartesiam.AI tar sig an alla dessa problem med sin NanoEdge AI Studio. Låt mig förklara hur.

Att kvantifiera ökningen av AI och ML

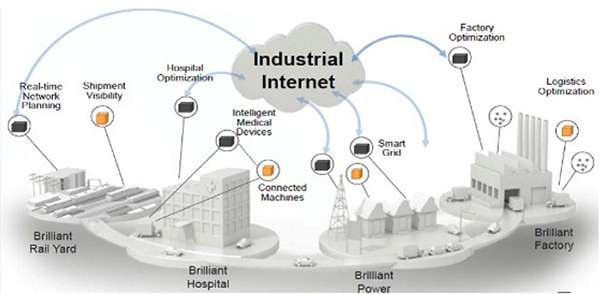

I mitten av 2020 förväntas det, beroende på källa, finnas mellan 20 och 30 miljarder molnkantsenheter (edge devices) världen över,1,2 där termen edge device avser uppkopplade enheter och sensorer i kanten av internet där gränsen går mot den fysiska världen. Av dessa kommer endast cirka 0,3 % att förses med AI- och ML-förmåga. Det uppskattas vidare att det kommer att finnas någonstans mellan 40 och 75 miljarder sådana enheter till år 2025,3,4 då det också förväntas att minst 25 % kommer behöva vara försedda med AI- och ML-förmågor.

En stor faktor när det gäller industriella installationer är att göra befintliga "dumma" maskiner "smarta" genom att utöka dem med AI- och ML-förmågor. Det är svårt att överskatta potentialen här; exempelvis uppskattas det finnas befintlig dum (gammal) infrastruktur och maskiner till ett värde av 6,8 biljoner USD bara i USA.5

Hur ska AI och ML göras effektivare i kanten av molnet?

Sakernas internet (IoT) och Industriellt IoT (IIoT) är redan en utbredd teknologi och fysiska saker är redan uppkopplade — nästa utmaning är att göra dessa saker smarta.

Det traditionella sättet att skapa en AI/ML-applikation är att definiera en neural nätverksarkitektur, inklusive antalet neurala skikt, antalet neuroner per lager, och sättet på vilket de olika neuronerna och skikten är sammanlänkade. Nästa steg är att komma över en kvalificerad datamängd (som i sig själv har tagit enorma mängder tid och resurser att skapa). Datamängden används för att träna nätverken i molnet (dvs. använda ett stort antal kraftfulla servrar med ofantlig beräkningskapacitet). Slutligen överförs det tränade nätverket till en form som är lämplig installera i apparaten i molnkanten.

Enligt IBM Quant Crunch Report,6 är datavetenskap och -analys (DSA) inte längre modeord; de är snarast väsentliga affärsverktyg. Dock finns en växande oro att upplärningen av personer med DSA-färdigheter släpar efter farligt mot efterfrågan, med en brist på 130 000 datavetare för närvarande i bara USA.

Tyvärr utgör bristen på tillgång till skickliga datavetare och kvalificerade datamängder hinder för ett snabbt och prisvärt framtagande av AI/ML-utrustade smarta saker. Enligt Cisco,7 är misslyckandefrekvensen för IoT-projekt i allmänhet cirka 74 %, och denna felfrekvens är högre när det gäller projekt med AI/ML-förmågor.

Enligt IDC,8 finns det cirka 22 miljoner mjukvaruutvecklare i världen. Av dessa har cirka 1,2 miljoner fokus på inbäddade system, och av dessa har endast cirka 0,2 % ens minimala AI/ML-färdigheter.

Vissa AI- och ML-system, såsom maskinseende för föremålsdetektering och -identifiering, kräver användning av speciella, kraftfulla beräkningsprocessorer, inklusive grafikprocessorer (GPU) och/eller fältprogrammerbara grindmatriser (FPGA:er). Dock innebär den nya utvecklingen inom AI/ML-tekniken att en stor majoritet av ej maskinseende AI/ML-applikationer kan installeras på relativt enkla microcontrollers som är vanliga i inbäddade system.

År 2020, enligt Statista,9 förväntas de globala leveranserna av microcontrollers uppgå till cirka 28 miljarder enheter (det är ungefär 885 st. i sekunden!), vilket gör microcontrollerbaserade plattformar till den mest utbredda hårdvaran på marknaden. Med sin låga kostnad och låga strömförbrukning, är microcontrollers den perfekta plattformen för att föra ut intelligensen till molnkanten.

Även för stora företagsorganisationer med tillgång till datavetare och datamängder och närmast obegränsade budgetar, är det svårt att bli experter på AI och ML. För mindre företag kan det vara omöjligt. Om situationen fortsätter som nu, finns det ingen chans att 25 % av apparaterna i molnkanten kommer att vara försedda med AI/ML-förmågor till 2025. Men tänk om befintliga utvecklare av microcontrollerbaserade inbäddade system kunde lära sig utveckla AI/ML-applikationer...

Ett enkelt, snabbt och prisvärt sätt att utveckla AI/ML-försedda smarta saker

Den vanligast förekommande processorplattformen för inbäddade applikationer i industriella miljöer är microcontrollern, och ingen microcontroller är vanligare än Arms Cortex-M-familj, särskilt M0, M0+, M3, M4 och M7.

Figur 1: V2M-MPS2-0318C är en kraftfull utvecklingsplattform för Arm Cortex-M-baserade applikationer med massor av I/O och en LCD-display. (Bildkälla: Arm)

Figur 1: V2M-MPS2-0318C är en kraftfull utvecklingsplattform för Arm Cortex-M-baserade applikationer med massor av I/O och en LCD-display. (Bildkälla: Arm)

En sak som företag har tillgång till är traditionella inbäddade utvecklare. Det som krävs är något sätt att få dessa utvecklare att agera som AI/ML-experter utan att behöva utbilda dem. Den idealiska lösningen skulle vara att ge traditionella inbäddade utvecklare förmågan att snabbt och enkelt skapa självmedvetna maskiner som automatiskt kan lära sig och förstå sin miljö, identifiera mönster och detektera oregelbundenheter, förutspå problem och utfall, och göra allt detta på prisvärda microcontrollerplattformar i molnkanten där datan genereras och registreras.

Lösningen, som jag anspelade på tidigare, är NanoEdge AI Studio från Cartesiam.AI. Med denna inbyggda utvecklingsmiljö (IDE), som körs på Windows 10 eller Linux Ubuntu, väljer den inbäddade utvecklaren först önskad microcontroller, bland ett urval som sträcker sig från Arm Cortex-M0 till M7. Utvecklaren eller konstruktören anger också maximal mängd RAM som ska allokeras till lösningen. Om du är lite rostig eller ny inför allt detta, är ett bra ställe att börja (om) på V2M-MPS2-0318C Arm Cortex-M Prototyping System+ (figur 1).

V2M-MPS2-0318C är en del av Arm Versatile Express-sortimentet av utvecklingskort. Det levereras med en relativt stor FPGA för prototypkonstruktion av Cortex-M-baserade konstruktioner. För det ändamålet levereras den med fast krypterade FPGA-implementationer av alla Cortex-M-processorer. Den har också åtskilliga användbara kringenheter inklusive PSRAM, Ethernet, pekskärm, ljud, en VGA-LCD, SPI och GPIO.

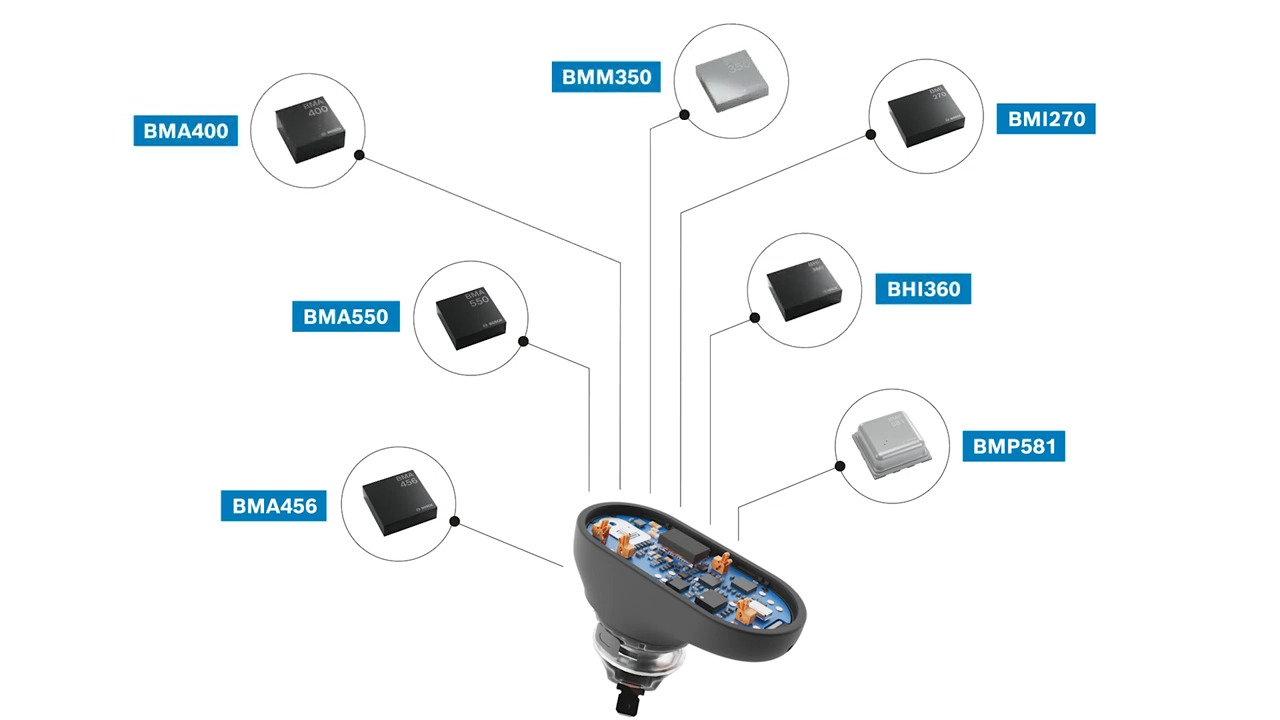

Härnäst behöver utvecklarna välja hur många och vilka sensorer som ska användas; skönheten i Cartesiam.AI:s tillvägagångssätt är att det inte finns några hårda begränsningar av sensorerna som kan användas. Exempelvis kan dessa omfatta:

- En-, två- och tre-axliga accelerometrar (för i princip valfri frekvens för vibrationsanalys)

- Magnetsensorer

- Temperatursensorer

- Mikrofoner (för ljudidentifiering)

- Halleffekt-sensorer för motorstyrning

- Strömövervakningssensorer

Det är viktigt att notera att utvecklaren inte behöver definiera specifika artikelnummer — bara de allmänna sensortyperna.

Nästa steg är att ladda kontextuell sensordata; alltså universell data förknippad med varje sensor för att ge systemet en idé om vad det kommer träffa på.

NanoEdge AI Studio är försedd med en omfattande uppsättning AI/ML-"byggblock" som kan användas för att skapa lösningar för 90 % eller mer av industriella AI/ML-uppgifter. När denna har informerats om önskad microcontroller, antal och typer av sensorer och den universella typen av sensordata som den kan förvänta sig se, kommer den att generera den bästa AI/ML-bibliotekslösningen utav 500 miljoner möjliga kombinationer.

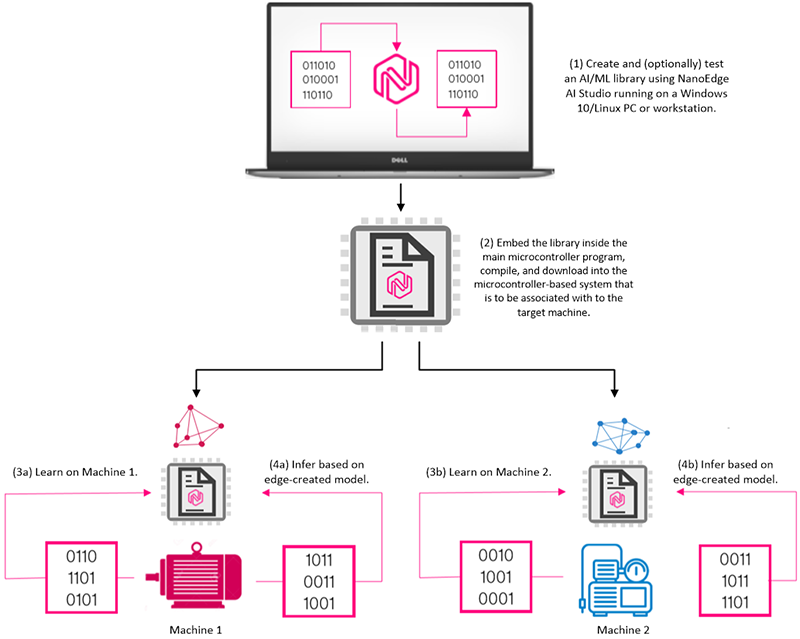

Om utvecklaren så önskar, kan denna lösning också testas på samma PC som kör NanoEdge AI Studio IDE genom en inkluderad emulator, efter vilket den bäddas in i microcontrollerns huvudprogram, kompileras och laddas ned till det microcontrollerbaserade systemet som ska associeras med målmaskinen.

Bara för exemplet skull: låt oss anta att vi har två dumma maskiner som vi önskar göra smarta. En av dessa maskiner kan vara en pump, och den andra kan vara en generator. Låt oss vidare, också för exemplets skull, anta att vi skapar en enda lösning som använder en temperatursensor och en 3-axlig accelerometer och att samma lösning installeras på båda maskinerna (figur 2).

Figur 2: Efter att NanoEdge AI Studio IDE har använts till att skapa och eventuellt testa ett AI/ML-bibliotek, inbäddas det biblioteket i huvudprogrammet, kompileras och laddas ned till det microcontrollerbaserade system som ska förknippas med målmaskinen(-erna). Efter en inlärningsfas (typiskt sett en vecka med 24-timmarsdrift), kan inferensmotorn användas för att upptäcka och rapportera oregelbundenheter och förutspå framtida utfall. (Bildkälla: Max Maxfield)

Figur 2: Efter att NanoEdge AI Studio IDE har använts till att skapa och eventuellt testa ett AI/ML-bibliotek, inbäddas det biblioteket i huvudprogrammet, kompileras och laddas ned till det microcontrollerbaserade system som ska förknippas med målmaskinen(-erna). Efter en inlärningsfas (typiskt sett en vecka med 24-timmarsdrift), kan inferensmotorn användas för att upptäcka och rapportera oregelbundenheter och förutspå framtida utfall. (Bildkälla: Max Maxfield)

Naturligtvis kommer dessa två maskiner ha fullständigt olika egenskaper. I verkligheten kommer två annars identiska maskiner att ha väldigt olika karakteristik beroende på deras placering och omgivning. Exempelvis kommer två identiska pumpar placerade 20 meter från varandra i samma utrymme i samma fabrik exponeras för olika vibrationsprofiler beroende på var de är monterade (en på betong, den andra ovanpå golvbjälkar i trä) och längden (och formen och materialet) på rören till vilka de är anslutna.

Nyckel till hela processen är att AI/ML-lösningar tränas upp individuellt på kända, bra maskiner, där denna utbildning typiskt sett tar en veckas med oavbruten drift 24 timmar/dygn, vilket gör det möjligt för systemet att lära sig av temperaturfluktuationer och vibrationsmönster. Ytterligare utbildningssessioner kan naturligtvis genomföras vid senare tillfällen för att finjustera modellerna till att ta hänsyn till miljövariationer som är förknippade med olika säsonger (för externa tillämpningar) och andra förväntade variabler.

När lösningen har tränats upp, kan de börja dra slutsatser från all ny data som kommer in, identifiera mönster och detektera oregelbundenheter, förutsäga problem och utfall, samt presentera sina slutsatser på en kontrollpanel för både tekniska och affärsmässiga analyser efter behov.

Slutsatser

Jag hävdar att NanoEdge AI Studio ritar om kartan. Den är intuitiv och kommer göra det möjligt för utvecklare av inbäddade system att använda strömsnåla, billiga Arm Cortex-M-microcontrollers — som finns inbäddade i miljarder apparater världen över — att snabbt, enkelt och billigt integrera AI/ML i sina industriella system, förvandla dumma maskiner till smarta maskiner och därmed öka produktiviteten och effektiviteten, och samtidigt även uppnå hett efterlängtade besparingar av driftskostnader.

Referenser

1: https://www.vxchnge.com/blog/iot-statistics

2: https://securitytoday.com/articles/2020/01/13/the-iot-rundown-for-2020.aspx

3: https://www.helpnetsecurity.com/2019/06/21/connected-iot-devices-forecast/

4: https://securitytoday.com/articles/2020/01/13/the-iot-rundown-for-2020.aspx

5: https://www.kleinerperkins.com/perspectives/the-industrial-awakening-the-internet-of-heavier-things/

6: https://www.ibm.com/downloads/cas/3RL3VXGA

7: https://newsroom.cisco.com/press-release-content?articleId=1847422

8: https://www.idc.com/getdoc.jsp?containerId=US44363318

9: https://www.statista.com/statistics/935382/worldwide-microcontroller-unit-shipments/

Have questions or comments? Continue the conversation on TechForum, DigiKey's online community and technical resource.

Visit TechForum