Hur man optimerar intralogistik för att effektivisera och påskynda leveranskedjor för Industry 4.0 - Del två av två

Bidraget med av DigiKeys nordamerikanska redaktörer

2023-09-22

Första delen i denna serie om intralogistik diskuterade frågor relaterade till hur autonoma mobila robotar (AMR) och automatiskt styrda fordon (AGV) används på systemnivå för att implementera intralogistik och snabbt och säkert flytta gods efter behov. Den här artikeln fokuserar på användningsfall och hur autonoma mobila robotar och automatiskt styrda fordon använder sensorer för att identifiera och spåra gods, hur maskininlärning (ML) och artificiell intelligens (AI) stödjer godsidentifiering, rörelse och leverans av gods genom lager- och produktionsanläggningar.

Intralogistik (intern logistik) använder autonoma mobila robotar och automatiskt styrda fordon för att effektivt flytta gods i lager och produktionsanläggningar enligt Industry 4.0. För att effektivisera och snabba upp leveranskedjor behöver intralogistiksystemen känna till godsets nuvarande position, godsets avsedda destination och vilken väg som är säkrast och mest effektiv för att godset ska nå destinationen. Denna effektiva navigering kräver en mängd olika sensorer.

Automatiskt styrda fordon och autonoma mobila robotar använder sensorer för att öka sin situationsmedvetenhet i intralogistiska lösningar. Matriser för sensorer tillhandahåller säkerhet för personal i närheten, skydd för annan utrustning samt effektiv navigering och lokalisering. Beroende på kraven för tillämpningen kan sensorteknologier för autonoma mobila robotar omfatta kontaktsensorer som t.ex. gränslägesbrytare inbyggda i stötfångare, två- och tredimensionell ljusdetektering och avståndsmätning (LiDAR), ultraljud, kameror med tvådimensionell teknologi och stereoteknologi, radar, kodare, enheter för tröghetsmätning (IMU) och fotoceller. För automatiskt styrda fordon kan sensorerna vara av typen magnetiska, induktiva eller optiska linjesensorer. Det kan även vara gränslägesbrytare inbyggda i stötfångare, tvådimensionell LiDAR och kodare.

Den första artikeln i denna serie behandlar frågor som rör hur autonoma mobila robotar och automatiskt styrda fordon används på systemnivå för att implementera intralogistik och effektivt flytta gods efter behov.

Den här artikeln fokuserar på sensorfusion och på hur autonoma mobila robotar och automatiskt styrda fordon använder kombinationer av sensorer samt artificiell intelligens och maskininlärning för lokalisering, navigering och driftsäkerhet. Artikeln inleds med en kort genomgång av vanliga sensorer för automatiskt styrda fordon, undersöker robotlägen samt algoritmer för SLAM (samtidig placering och kartläggning) med hjälp av sensorfusion, tar upp hur uppskattningar med SLAM kan förbättras med matchningsteknikerna skanning-till-karta och skanning-till-skanning samt avslutar med en titt på hur sensorfusion bidrar till säker drift för autonoma mobila robotar och automatiskt styrda fordon. DigiKey tillhandahåller ett brett utbud av sensorer och brytare för robotteknikkonstruktörer men även för andra industriella tillämpningar i alla dessa fall.

En mängd olika sensorer och sensorfusioner, artificiell intelligens, maskininlärning och trådlös anslutning behövs för att stödja autonom drift och säkerhet i autonoma mobila robotar. Även om effektivitetskraven för automatiskt styrda fordon är lägre, är de fortfarande beroende av en mängd sensorer för att stödja säker och effektiv drift. Det finns två övergripande kategorier av sensorer.

- Proprioceptiva sensorer mäter värden som är interna för roboten, som t.ex. hjulhastighet, belastning, batteriladdning med mera.

- Exteroceptiva sensorer ger information om robotens omgivning, som t.ex. avståndsmätning, var landmärken finns samt identifiering av hinder, som t.ex. personer som befinner sig i robotens väg.

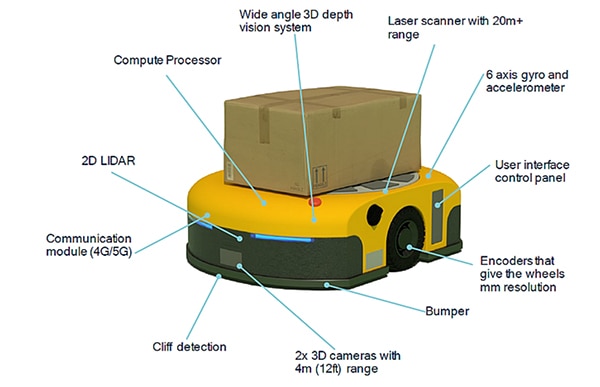

Sensorfusioner i automatiskt styrda fordon och autonoma mobila robotar bygger på kombinationer av proprioceptiva och exteroceptiva sensorer. Exempel på sensorer för autonoma mobila robotar är (figur 1):

- Laserskanner för objektdetektering med en räckvidd på mer än 20 m

- Tröghetsmätare med sex axlar och gyroskop samt accelerometer, och ibland även en magnetometer

- Kodare med millimeterupplösning på hjulen

- Kontaktsensor, som t.ex. en mikrobrytare i stötfångaren, som omedelbart stoppar rörelsen om ett oväntat föremål kommer i kontakt med den

- Två kameror med tredimensionell teknik riktade framåt, med en räckvidd på 4 m

- Sensor riktad nedåt för att upptäcka kanten på en plattform (så kallad kantdetektering)

- Kommunikationsmoduler som tillhandahåller anslutningsmöjligheter och som valfritt kan erbjuda avkänning för ankomstvinkel (AoA) och avgångsvinkel (AoD) för Bluetooth-lokaliseringstjänster i realtid (RTLS), eller sändnings-/mottagningspunkter (TRP) för 5G för att plotta ett rutnät med en noggrannhet på centimeternivå

- Tvådimensionell LiDAR för att beräkna avstånd till hinder framför fordonet

- Tredimensionellt djupseende med vidvinkel som lämpar sig för identifiering och lokalisering av objekt

- Inbyggd, högeffektiv beräkningsprocessor för sensorfusion, artificiell intelligens och maskininlärning

Figur 1: Exempel på en autonom mobil robot som visar de inbyggda sensorernas mångfald och placering. (Bildkälla: Qualcomm)

Figur 1: Exempel på en autonom mobil robot som visar de inbyggda sensorernas mångfald och placering. (Bildkälla: Qualcomm)

Robotens läge och sensorfusion

Navigering för autonoma mobila robotar är en komplicerad process. Ett av de första stegen är att den autonoma mobila roboten vet var den befinner sig och åt vilket håll den är riktad. Denna kombination av data kallas robotens läge. Begreppet läge kan också tillämpas på armar och robotverktyg för stationära robotar som har flera axlar. Sensorfusion kombinerar data från tröghetsmätare, kodare och andra sensorer för att bestämma läget. Lägesalgoritmen uppskattar robotens position (x, y) och orienteringsvinkel θ, med avseende på koordinataxlarna. Funktionen q = (x, y, θ) definierar robotens läge. För autonoma mobila robotar har lägesinformation en mängd olika användningsområden, bland annat:

- Läget för en obehörig person, t.ex. en person som går nära roboten, i förhållande till en extern referensram eller i förhållande till roboten

- Robotens uppskattade läge efter att ha rört sig med en given hastighet under en förutbestämd tid

- Beräkning av den hastighetsprofil som krävs för att roboten ska kunna förflytta sig från sitt nuvarande läge till ett andra läge

Läge är en fördefinierad funktion i flera utvecklingsmiljöer för robotmjukvaror. Paketet robot_pose_ekf ingår till exempel i rOS (Robot Operating System), en utvecklingsplattform med öppen källkod. Robot_pose_ekf kan användas för att uppskatta robotens tredimensionella läge baserat på (partiella) lägesmätningar från olika sensorer. Den använder ett utökat Kalman-filter med en sexdimensionell modell (tredimensionellt läge och tredimensionell orientering) för att kombinera mätningar från kodaren för hjulens odometri, en kamera för visuell odometri samt från tröghetsmätaren. Eftersom de olika sensorerna arbetar med olika hastigheter och latenser kräver robot_pose_ekf inte att all sensordata är tillgänglig kontinuerligt eller samtidigt. Varje sensor används för att ge en uppskattning av läget med en kovarians. Robot_pose-ekf identifierar den tillgängliga sensorinformationen vid varje tidpunkt och anpassar sig därefter.

Sensorfusion och SLAM

Många miljöer där autonoma mobila robotar används innehåller varierande hinder som kan flyttas från tid till annan. Även om en grundläggande karta över anläggningen är användbar, är det inte tillräckligt. När autonoma mobila robotar rör sig i en industrianläggning behöver de mer än bara lägesinformation, de använder även SLAM för att säkerställa effektiv drift. SLAM lägger till kartläggning av omgivningen i realtid för att stödja navigering. Två grundläggande metoder för SLAM är:

- Visuell SLAM som kombinerar en kamera med en tröghetsmätare

- LiDAR SLAM som kombinerar en lasersensor som exempelvis en två- eller tredimensionell LiDAR med en tröghetsmätare

LiDAR SLAM kan vara mer exakt än visuell SLAM, men den är i allmänhet dyrare att implementera. Alternativt kan 5G användas för att tillhandahålla positioneringsinformation för att förbättra visuella uppskattningar för SLAM. Användningen av privata 5G-nätverk i lager och fabriker kan komplettera inbyggda sensorer för SLAM. Vissa autonoma mobila robotar implementerar exakt inomhusposition med hjälp av sändnings-/mottagningspunkter (TRP) för 5G för att plotta ett rutnät med centimeterprecision på x-, y- och z-axlarna.

Framgångsrik navigering är beroende av förmågan hos autonoma mobila robotar att anpassa sig till föränderliga miljöfaktorer. Navigering kombinerar visuell SLAM och/eller LiDAR SLAM samt överlagringsteknik som sändnings-/mottagningspunkter för 5G och maskininlärning för att upptäcka förändringar i miljön och tillhandahålla ständiga positionsuppdateringar. Sensorfusion stödjer SLAM på flera sätt:

- Kontinuerliga uppdateringar av den rumsliga och semantiska modellen av miljön baserat på data från olika sensorer med hjälp av artificiell intelligens och maskininlärning

- Identifiering av hinder, så att färdplanens algoritmer kan göra nödvändiga justeringar och hitta den mest effektiva vägen genom miljön

- Implementering av färdplanen, vilket kräver realtidsstyrning för att ändra den planerade rutten, inklusive hastighet och riktning för autonoma mobila robotar, när miljön förändras

När SLAM inte räcker till

SLAM är ett viktigt verktyg för effektiv navigering för autonoma mobila robotar, men enbart SLAM är inte tillräckligt. Liksom lägesalgoritmer implementeras SLAM med ett utökat Kalman-filter som tillhandahåller uppskattade värden. Värden uppskattade för SLAM utökar lägesinformationen och lägger bland annat till linjära hastigheter, rotationshastigheter samt linjära accelerationer. Uppskattningar för SLAM är en process i två steg: det första steget sammanställer förutsägelser med hjälp av analyser från interna sensorer baserade på fysiska rörelselagar. Det återstående steget i beräkningen för SLAM kräver avläsningar från externa sensorer för att förfina de ursprungliga beräkningarna. Denna tvåstegsprocess gör det lättare att eliminera och korrigera små fel som med tiden kan ackumuleras och skapa betydande fel.

SLAM är beroende av sensoringångarnas tillgänglighet. Tvådimensionell LiDAR, som är förhållandevis billig, fungerar inte i vissa fall. Ett exempel kan vara om det inte finns några objekt i sensorns direkta siktlinje. I dessa fall kan stereokameror med tredimensionell teknik eller tredimensionell LiDAR förbättra systemets effektivitet. Stereokameror med tredimensionell teknik eller tredimensionell LiDAR är dock dyrare och kräver mer datorkraft för att implementeras.

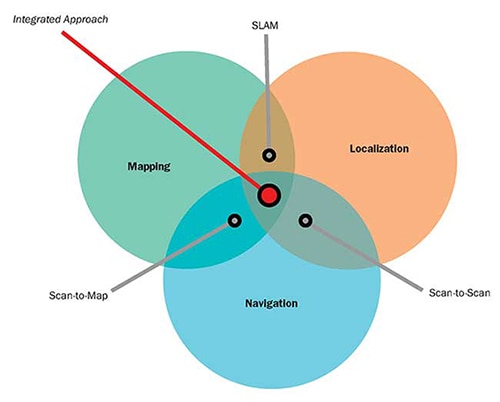

Ett annat alternativ är att använda ett navigationssystem som integrerar SLAM med matchningstekniker för skanning-till-karta och skanning-till-skanning som kan implementeras genom användning av enbart tvådimensionella LiDAR-sensorer (figur 2):

- Matchningen skanning-till-karta använder data för avståndsmätning från LiDAR för att uppskatta autonoma mobila robotars position genom att jämföra avståndsmätningarna med en lagrad karta. Hur effektiv denna metod är beror på hur exakt kartan är. Den påverkas inte av avvikelser över tid, men i repetitiva miljöer kan den leda till fel som är svåra att identifiera, som kan orsaka inkonsekventa förändringar i den upplevda positionen och kan vara svåra att bortse från.

- Matchningen skanning-till-skanning använder sekventiell räckviddsdata från LiDAR för att uppskatta positionen för en autonom mobil robot mellan skanningarna. Metoden tillhandahåller uppdaterad information om plats och läge för autonoma mobila robotar oberoende av någon befintlig karta och kan vara användbar vid skapande av kartor. Det är dock en inkrementell algoritm som kan förskjutas över tid utan att det går att identifiera de felaktigheter som påverkas.

Figur 2: Matchningsalgoritmerna skanning-till-karta och skanning-till-skanning kan användas för att komplettera och förbättra SLAM-systemens effektivitet. (Bildkälla: Aethon)

Figur 2: Matchningsalgoritmerna skanning-till-karta och skanning-till-skanning kan användas för att komplettera och förbättra SLAM-systemens effektivitet. (Bildkälla: Aethon)

Säkerhet kräver sensorfusion

Säkerhet är en viktig fråga för automatiskt styrda fordon och autonoma mobila robotar, och flera standarder måste beaktas. Några exempel är: ANSI/ITSDF B56.5 - 2019 (American National Standards Institute/Industrial Truck Standards Development Foundation), Säkerhetstandarder för förarlösa automatiskt styrda fordon och automatiserade funktioner för bemannade industrifordon, ANSI/RIA (Robotic Industrial Association) R15.08-1-2020 - Standard för industriella mobila robotar - Säkerhetskrav, flera standarder från Internationella standardiseringsorganisationen (ISO) m.fl.

Säker drift av automatiskt styrda fordon och autonoma mobila robotar som kombinerar säkerhetscertifierade tvådimensionella LiDAR-sensorer (ibland kallade säkerhetslaserskannrar) med kodare på hjulen. Tvådimensionell LiDAR stödjer två detekteringsavstånd samtidigt, kan ha en avkänningsvinkel på 270° och koordineras med den fordonshastighet som rapporteras av kodarna. När ett föremål detekteras i den bortre detekteringszonen (upp till 20 m bort, beroende på sensor) kan fordonet saktas ned vid behov. Om objektet kommer in i körriktningens närmaste detekteringszon stannar fordonet.

Säkerhetslaserskannrar används ofta i uppsättningar om fyra, med en placerad i varje hörn av fordonet. De kan fungera som en enda enhet och kommunicera direkt med fordonets säkerhetsstyrning. Skannrarna är tillgängliga och certifierade för användning i säkerhetskategori 3, Pld (Performance Level d) och SIL2 (Safety Integrity Level 2) och är inkapslade i ett IP65-hölje som är lämpligt för de flesta tillämpningar både utomhus och inomhus (figur 3). Skannrarna har en ingång för inkrementell information från hjulens kodare för att stödja sensorfusion.

Figur 3: Tvådimensionella LiDAR-sensorer som denna kan kombineras med kodare på hjulen i ett sensorfusionssystem som möjliggör säker drift för autonoma mobila robotar och automatiskt styrda fordon. (Bildkälla: Idec)

Figur 3: Tvådimensionella LiDAR-sensorer som denna kan kombineras med kodare på hjulen i ett sensorfusionssystem som möjliggör säker drift för autonoma mobila robotar och automatiskt styrda fordon. (Bildkälla: Idec)

Sammanfattning

Intralogistik stödjer snabbare och effektivare leveranskedjor i lager och fabriker som har implementerat Industry 4.0. Inom intralogistik är autonoma mobila robotar och automatiskt styrda fordon viktiga verktyg för att flytta gods från plats till plats på ett snabbt och säkert sätt. Sensorfusion är nödvändigt för att stödja funktioner för autonoma mobila robotar och automatiskt styrda fordon, inklusive att fastställa läge, beräkna SLAM-data, förbättra navigeringseffektiviteten med hjälp av matchning av skanning-till-karta och skanning-till-skanning samt säkerställa säkerheten för personal och föremål i hela anläggningen.

Disclaimer: The opinions, beliefs, and viewpoints expressed by the various authors and/or forum participants on this website do not necessarily reflect the opinions, beliefs, and viewpoints of DigiKey or official policies of DigiKey.